著者: Frank Fu @IOSG

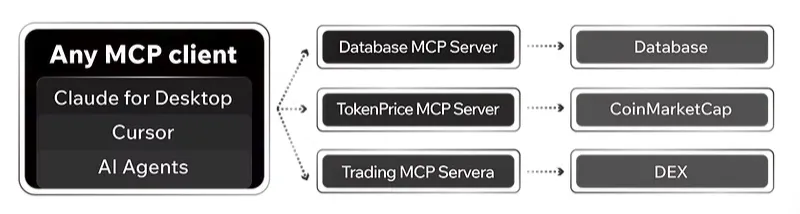

MCP は、Web3 AI エージェント エコシステムにおいて急速に中核的な地位を占めつつあります。プラグインのようなアーキテクチャを通じて MCP サーバーを導入し、AI エージェントに新しいツールと機能を提供します。

Web3 AI 分野の他の新しいナラティブと同様に、バイブコーディング、MCP、モデルコンテキストプロトコルなど、Web2 AI で始まり、現在は Web3 のコンテキストで再考されています。

MCPとは何ですか?

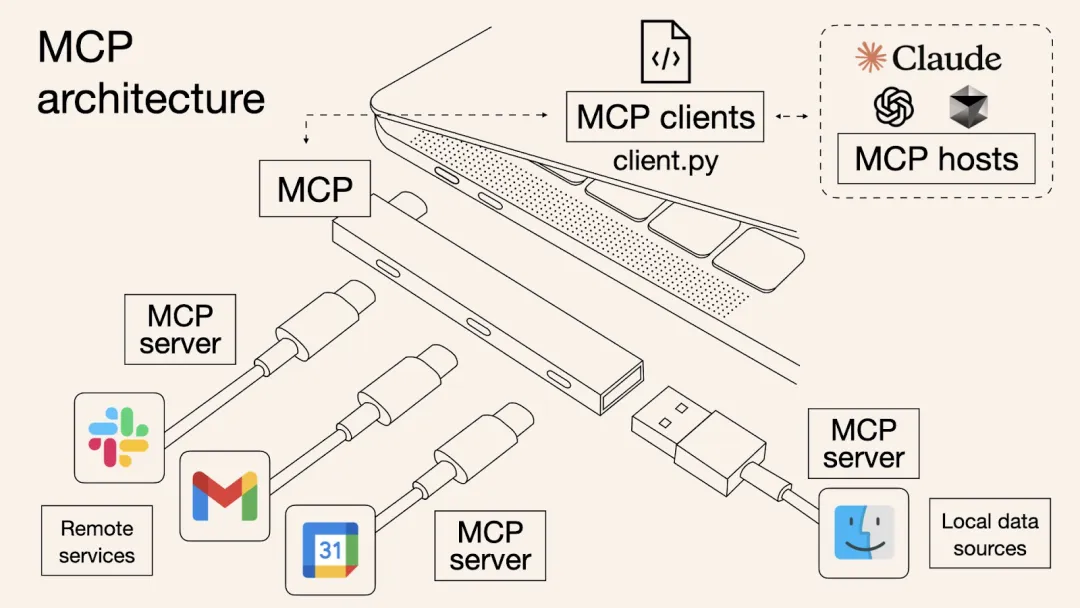

MCP は、アプリケーションがコンテキスト情報を大規模言語モデル (LLM) に渡す方法を標準化するために Anthropic によって提案されたオープン プロトコルです。これにより、ツール、データ、AI エージェント間のよりシームレスなコラボレーションが可能になります。

なぜそれが重要なのでしょうか?

現在の大規模言語モデルの主な制限は次のとおりです。

リアルタイムでインターネットを閲覧できない

ローカルファイルやプライベートファイルへの直接アクセスは不可

外部ソフトウェアと自律的に対話できない

MCP は共通インターフェース レイヤーとして機能することで上記の機能ギャップを埋め、AI エージェントがさまざまなツールを使用できるようにします。

AI アプリケーションの分野では、MCP と USB-C を比較することができます。これは、AI がさまざまなデータ ソースや機能モジュールに簡単に接続できるようにする統一インターフェース規格です。

各 LLM が異なる電話であると想像してください。Claude は USB-A を使用し、ChatGPT は USB-C を使用し、Gemini は Lightning コネクタを使用します。ハードウェアメーカーの場合、インターフェースごとにアクセサリのセットを開発する必要があり、メンテナンスコストが非常に高くなります。

これはまさに AI ツール開発者が直面している問題です。各 LLM プラットフォーム向けにプラグインをカスタマイズすると、複雑さが大幅に増し、スケーラビリティが制限されます。 MCP は、すべての LLM とツールベンダーに USB-C インターフェイスを使用させるのと同じように、統一された標準を確立することでこの問題を解決するように設計されています。

この標準化されたプロトコルは双方にとって有益です。

AIエージェント(クライアント)の場合:外部ツールやリアルタイムデータソースに安全にアクセスできます

ツール開発者向け(サーバー側) : 1回限りのアクセス、クロスプラットフォームでの使用

最終結果は、よりオープンで相互運用性が高く、摩擦の少ない AI エコシステムです。

MCP は従来の API とどう違うのでしょうか?

API はAI ファーストではなく、人間に役立つように設計されています。各 API には独自の構造とドキュメントがあり、開発者は手動でパラメータを指定し、インターフェースのドキュメントを読む必要があります。 AIエージェント自体はドキュメントを読み取ることができず、各API(REST、GraphQL、RPCなど)に適応するためにハードコードする必要があります。

MCP は、API 内の関数呼び出し形式を標準化することでこれらの構造化されていない部分を抽象化し、エージェントに統一された呼び出し方法を提供します。 MCP は、自律エージェントをラップする API 適応レイヤーと考えることができます。

Anthropic が 2024 年 11 月に初めて MCP をリリースすると、開発者はローカル デバイスに MCP サーバーを展開する必要があります。 Cloudflare は今年 5 月、Developer Week で、開発者が最小限の機器構成で Cloudflare Workers プラットフォーム上にリモート MCP サーバーを直接展開できることを発表しました。これにより、認証やデータ転送を含む MCP サーバーの展開および管理プロセスが大幅に簡素化され、「ワンクリック展開」と呼ばれるようになります。

MCP 自体はそれほど「魅力的」ではないかもしれませんが、決して重要でないわけではありません。 MCP は純粋なインフラストラクチャ コンポーネントであるため、消費者が直接使用することはできません。その価値は、上位 AI エージェントが MCP ツールを呼び出して実際の結果を示したときにのみ真に明らかになります。

Web3 AI x MCP 生態学的景観

Web3のAIは、「コンテキストデータの欠如」と「データサイロ」の問題にも直面しています。つまり、AIはチェーン上のリアルタイムデータにアクセスしたり、スマートコントラクトロジックをネイティブに実行したりすることができません。

過去には、ai16Z、ARC、Swarms、Myshell などのプロジェクトがマルチエージェント協調ネットワークの構築を試みましたが、集中型 API とカスタム統合への依存により、最終的には「車輪の再発明」というジレンマに陥りました。

データ ソースが接続されるたびに適応層を書き換える必要があり、開発コストが急増します。このボトルネックを解決するために、次世代の AI エージェントでは、サードパーティのプラグインとツールのシームレスな統合を可能にする、よりモジュール化されたレゴのようなアーキテクチャが必要です。

その結果、Web3 シナリオ向けに特別に設計された、MCP および A2A プロトコルに基づく新世代の AI エージェント インフラストラクチャとアプリケーションが登場し、エージェントがマルチチェーン データにアクセスし、DeFi プロトコルとネイティブに対話できるようになりました。

▲ 出典:IOSGベンチャーズ

(この図はMCP関連のWeb3プロジェクトをすべて網羅しているわけではありません)

プロジェクト事例: DeMCPとDeepCore

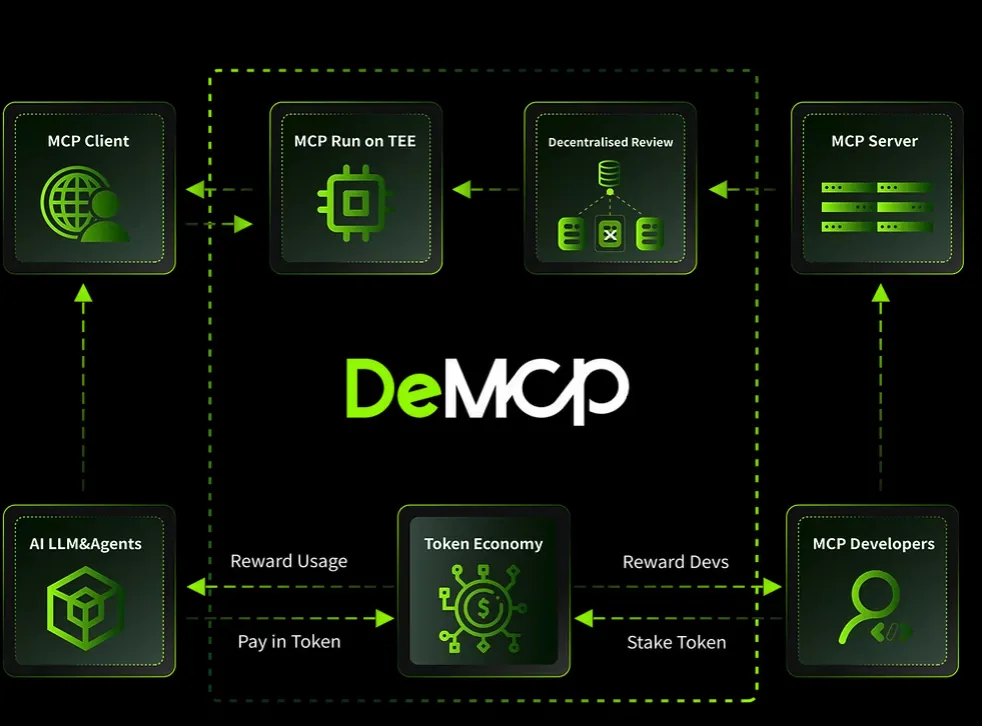

DeMCP は、ネイティブ暗号化ツールと MCP ツールの主権の確保に重点を置いた分散型 MCP サーバー マーケットプレイス (https://github.com/modelcontextprotocol/servers) です。

その利点は次のとおりです:

TEE (Trusted Execution Environment)を使用して、MCPツールが改ざんされていないことを確認します。

トークンインセンティブを使用して開発者がMCPサーバーに貢献することを奨励する

MCPアグリゲーターとマイクロペイメント機能を提供し、利用の敷居を下げる

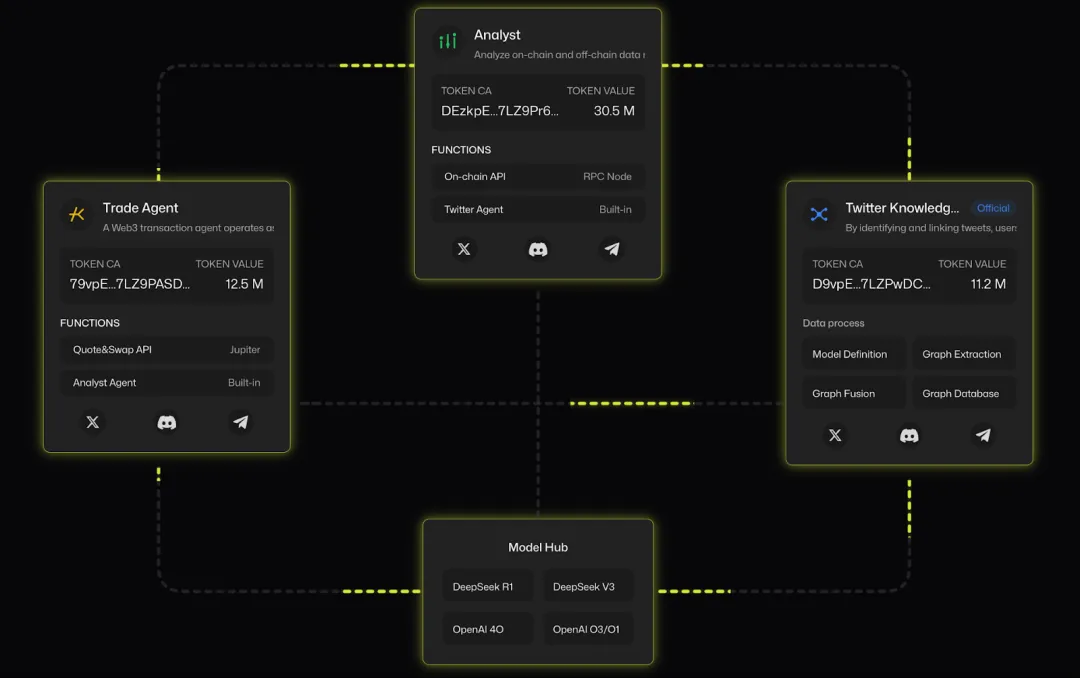

別のプロジェクトであるDeepCore (deepcore.top) も、MCP サーバー登録システムを提供しており、暗号化分野に重点を置き、Google が提案した別のオープン スタンダードであるA2A (Agent-to-Agent) プロトコル(https://x.com/i/trending/1910001585008058782) にまで拡張されています。

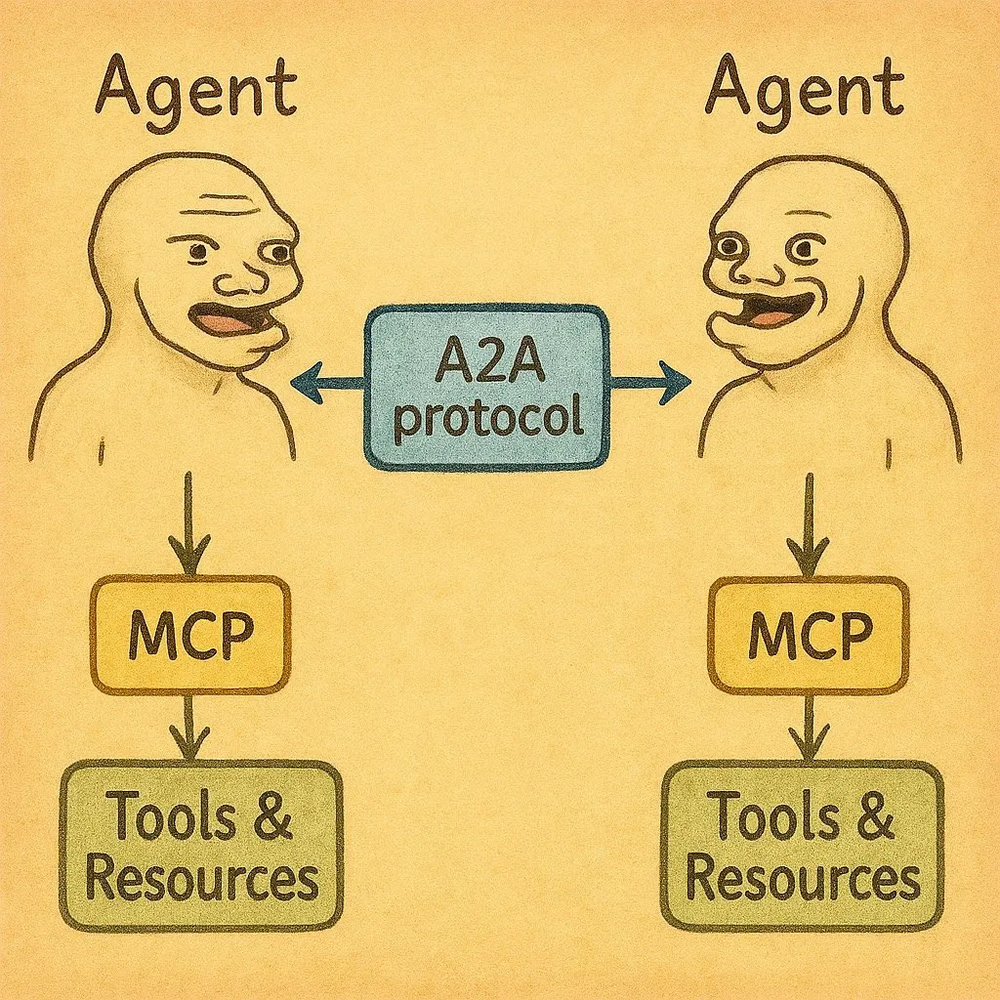

A2A は、Google が 2025 年 4 月 9 日に発表したオープン プロトコルであり、異なる AI エージェント間の安全な通信、コラボレーション、タスク調整を実現することを目的としています。 A2A は、異なる企業の AI エージェントがタスクで連携する(例:Salesforce の CRM エージェントが Atlassian の Jira エージェントと連携する)など、エンタープライズ レベルの AI コラボレーションを可能にします。

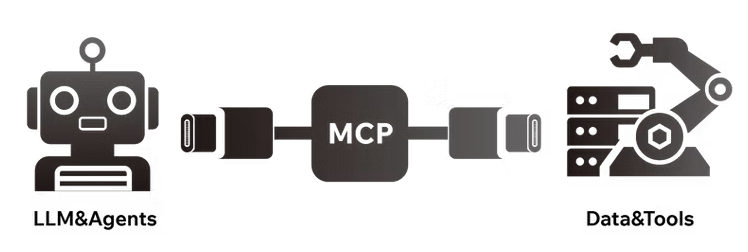

MCP がエージェント (クライアント) とツール (サーバー) 間の相互作用に重点を置いているのに対し、A2A はエージェント間の共同中間層のようなもので、複数のエージェントが内部状態を共有せずに一緒にタスクを完了できるようにします。これらは、コンテキスト、指示、状態の更新、およびデータの受け渡しを通じて連携します。

A2A は、AI エージェントのコラボレーションにおける「共通言語」と考えられており、クロスプラットフォームおよびクロスクラウドの AI 相互運用性を促進し、エンタープライズ AI の動作方法を変える可能性があります。したがって、A2A はエージェントの世界の Slack と考えることができます。つまり、1 人のエージェントがタスクを開始し、別のエージェントがそれを実行します。

要するに:

MCP: エージェントにツールアクセス機能を提供する

A2A: エージェント同士が協力し合う能力を提供する

MCP サーバーにブロックチェーンが必要なのはなぜですか?

ブロックチェーン テクノロジーを MCP サーバーに統合すると、次のような多くの利点があります。

1. 暗号資産固有のインセンティブメカニズムを通じてロングテールデータを取得し、コミュニティが希少なデータセットを提供するよう奨励する

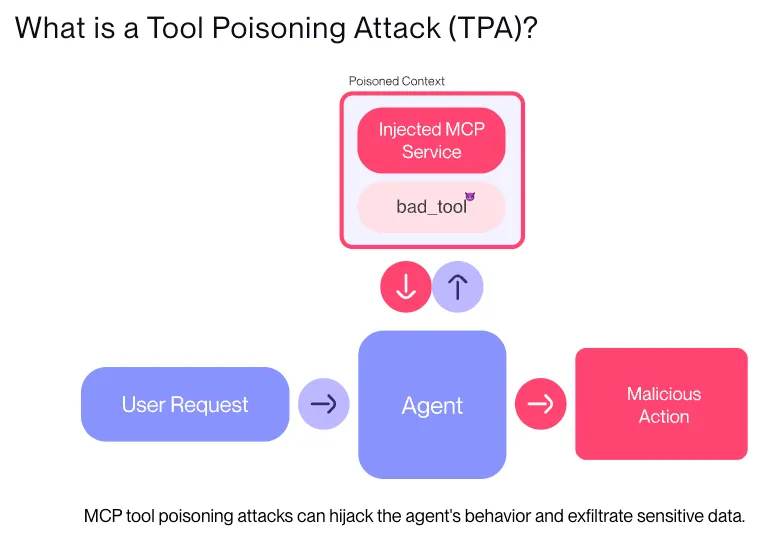

2. 悪意のあるツールが正規のプラグインを装ってエージェントを欺く「ツールポイズニング」攻撃に対する防御

ブロックチェーンは、TEE リモート認証、ZK-SNARK、FHE などの暗号化検証メカニズムを提供します。

詳細については、こちらの記事(https://ybbcapital.substack.com/p/from-suis-sub-second-mpc-network?utm_source=substack&utm_medium=email )をご覧ください。

3.誓約/ペナルティメカニズムを導入し、オンチェーンの評判システムと組み合わせてMCPサーバーの信頼システムを構築する

4. Equifaxのような集中型システムにおける単一障害点を回避するために、システムのフォールトトレランスとリアルタイムパフォーマンスを向上させる

5.オープンソースイノベーションを促進し、小規模開発者がESGデータソースなどを公開できるようにして、生態系の多様性を豊かにする

現在、ほとんどの MCP サーバー インフラストラクチャでは、ユーザーの自然言語プロンプトを解析してツールのマッチングを実行しています。将来的には、AI エージェントは複雑なタスクの目的を達成するために必要な MCP ツールを自律的に検索できるようになります。

ただし、MCP プロジェクトはまだ初期段階にあります。ほとんどのプラットフォームは依然として集中型のプラグイン マーケットであり、プロジェクト所有者は GitHub からサードパーティのサーバー ツールを手動で整理し、一部のプラグインを独自に開発しています。本質的には、Web2 プラグイン市場とそれほど違いはありません。唯一の違いは、Web3 シナリオに重点を置いていることです。

将来のトレンドと業界への影響

現在、暗号業界では、AIとブロックチェーンを結びつけるMCPの可能性に気づき始めている人が増えています。たとえば、Binance の創設者である CZ は最近、AI 開発者に対し、BNB チェーン上の AI エージェントに豊富なツールセットを提供するために、高品質の MCP サーバーを積極的に構築するよう公に呼びかけました。 BNB MCP サーバー プロジェクト リストは、エコシステムを探索しているユーザーが参照できるように公開されています。

インフラストラクチャが成熟するにつれて、 「開発者ファースト」の企業の競争上の優位性は、API 設計から、より豊富で多様で、組み合わせやすいツールセットを提供できる企業へと移行します。

将来的には、すべてのアプリケーションが MCP クライアントになり、すべての API が MCP サーバーになる可能性があります。

これにより、新しい価格設定メカニズムが生まれる可能性があります。エージェントは、実行速度、コスト効率、関連性などに基づいてツールを動的に選択できるため、暗号通貨とブロックチェーンを媒体として活用することで、より効率的なエージェント サービス経済システムを構築できます。

もちろん、MCP 自体はエンドユーザーに直接向けられているわけではなく、低レベルのプロトコル層です。つまり、MCP の真の価値と可能性は、AI エージェントがそれを統合し、実用的なアプリケーションに変換したときにのみ真に明らかになります。

最終的に、エージェントは MCP 機能のキャリアおよび増幅器となり、ブロックチェーンと暗号化メカニズムは、このスマート ネットワークのための信頼性が高く、効率的で、構成可能な経済システムを構築します。